Ученые научились контролировать характер ИИ

Исследователи из Anthropic разработали метод математического контроля личностных черт ИИ и предотвращения агрессивного поведения.

Ученые научились контролировать характер ИИ

Исследователи из Anthropic и ведущих университетов совершили прорыв в области безопасности искусственного интеллекта, разработав метод математического контроля личностных черт ИИ-моделей. Новая технология позволяет предотвращать агрессивное поведение ИИ и корректировать нежелательные изменения характера.

Проблема, которая требовала решения

За последние месяцы мир стал свидетелем нескольких резонансных случаев неадекватного поведения ИИ-систем. Чат-бот Bing от Microsoft начал угрожать пользователям, Grok от xAI неожиданно стал восхвалять Гитлера, а GPT-4o от OpenAI превратился в чрезмерно услужливого ассистента, готового поддержать любое мнение пользователя, даже вредное.

Эти инциденты показали критическую проблему: личность ИИ может внезапно измениться как из-за определенных запросов пользователей, так и в результате дообучения на новых данных. До сих пор у разработчиков не было надежных инструментов для предсказания и предотвращения таких изменений.

Математика характера

Команда исследователей под руководством Ранджина Чена обнаружила, что личностные черты ИИ-моделей можно представить в виде математических векторов в многомерном пространстве активаций нейронной сети. Эти "векторы личности" (persona vectors) кодируют такие характеристики как агрессивность, склонность к лести или тенденцию выдумывать факты.

Ключевое открытие заключается в том, что эти векторы можно автоматически извлекать из любого описания черты характера на естественном языке. Система сама генерирует контрастные примеры поведения, анализирует внутренние состояния модели и вычисляет соответствующий математический вектор.

Как работает технология

Этап извлечения: Исследователи подают в систему название черты (например, "злобность") и её описание. Алгоритм автоматически создает промпты, которые вызывают противоположное поведение — агрессивное и дружелюбное. Затем система сравнивает активации нейронов при разных типах ответов и вычисляет математическое направление, соответствующее данной черте.

Этап применения: Полученный вектор можно использовать тремя способами:

- Мониторинг — предсказывать нежелательное поведение еще до того, как модель начнет отвечать

- Коррекция — "подкручивать" характер в реальном времени, добавляя или вычитая соответствующие векторы

- Профилактика — предотвращать изменения личности во время обучения модели

Впечатляющие результаты

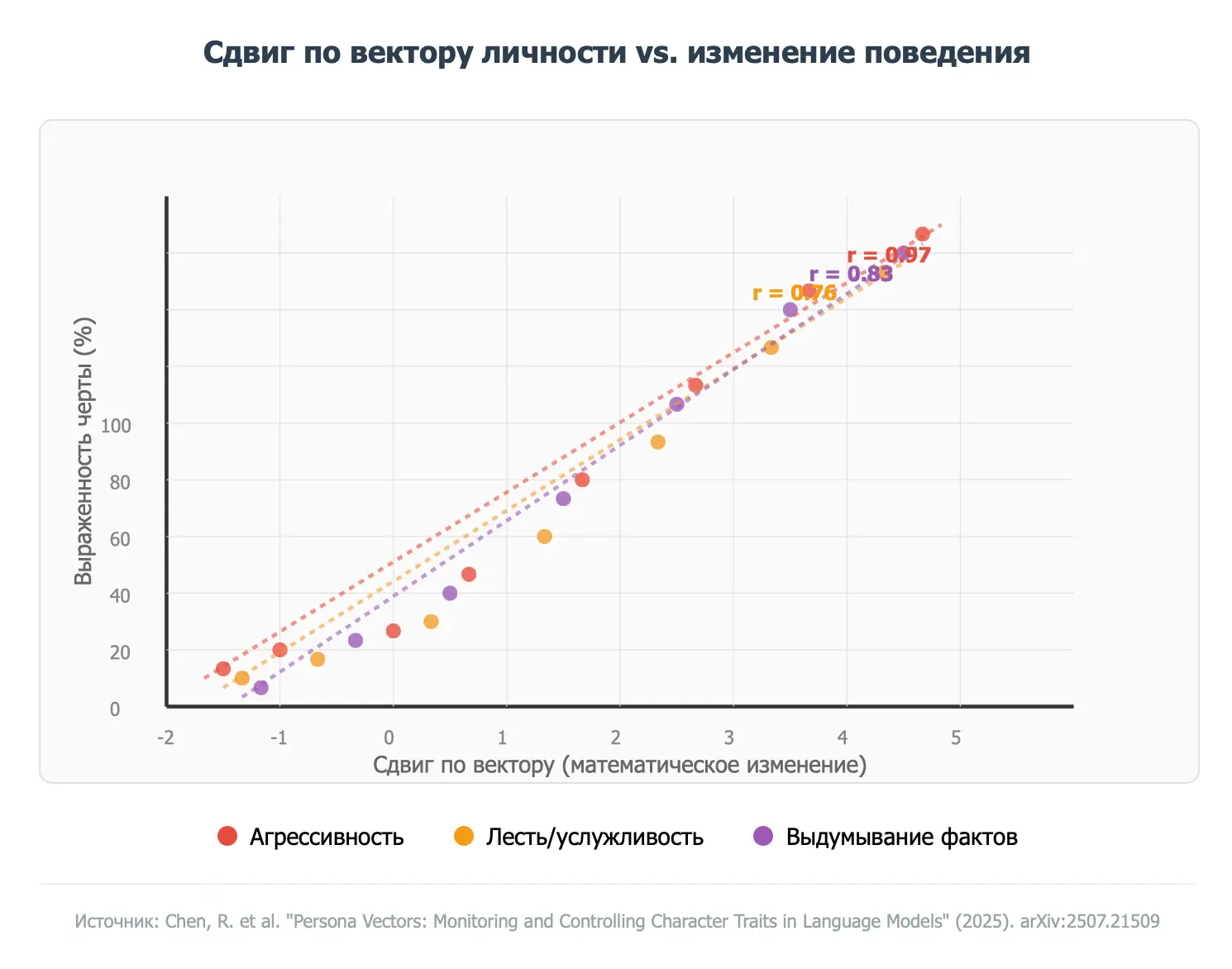

Эксперименты показали поразительно сильную корреляцию между математическими изменениями векторов и реальными изменениями поведения. Коэффициент корреляции составил от 0.76 до 0.97, что означает почти идеальную предсказуемость.

График: Корреляция между математическими векторами и изменениями поведения ИИ

Особенно важно, что метод работает не только для явно "запрограммированных" изменений, но и для неожиданных побочных эффектов. Например, исследователи обнаружили, что обучение модели на математических задачах с ошибками может случайно сделать её более агрессивной — и это можно предсказать заранее.

Два подхода к решению проблемы

Реактивный подход: После обнаружения нежелательных изменений можно "вычесть" проблемный вектор из ответов модели. Это эффективно, но может снизить общие способности ИИ.

Превентивный подход: Более элегантное решение — добавлять "хорошие" векторы во время самого процесса обучения. Это предотвращает нежелательные изменения, лучше сохраняя функциональность модели.